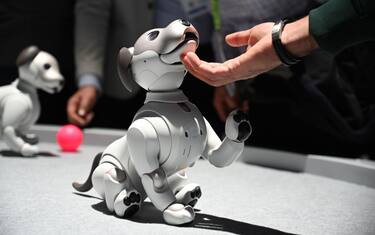

Androidi e algoritmi di apprendimento non provano emozioni ma iniziano a comprendere abbastanza bene quelle degli umani

Si è sempre ritenuto che il limite costitutivo dell'intelligenza artificiale potesse essere rappresentato dalle emozioni. Le macchine calcolano, percepiscono, agiscono, le più evolute imparano anche ma sono esenti dal lato emotivo dell'esperienza. I notevoli progressi nella biometria e negli algoritmi tramite cui le intelligenze artificiali sono istruite hanno portato però le macchine a un livello di comprensione delle emozioni umane sorprendente. Vediamo quali sono le tecnologie più usate e i progetti più interessanti in questo campo.

Intelligenza emotiva e affective computing

Di che cosa stiamo parlando innanzitutto? Il primo a utilizzare l'espressione "intelligenza emotiva" è stato lo psicologo Michael Beldoch verso la metà degli anni '60. Per intelligenza emotiva si intende la capacità di riconoscere le proprie emozioni e quelle dell'interlocutore e di reagire ad esse in modo consono ai propri obiettivi. Se sulle emozioni proprie i robot non possono ancora nulla, su quelle dell'interlocutore stanno compiendo enormi passi in avanti. L'intelligenza emotiva artificiale cerca di decodificare le emozioni umane dai segni che queste mostrano esternamente. Un ambito di ricerca noto anche come affective computing e oggetto di investimenti non indifferenti da parte di aziende, centri di ricerca universitari e governi.

Comunicazione testuale e verbale

Si parte per prima cosa da quel che l'interlocutore dice o scrive, che viene analizzato alla ricerca di marcatori per i differenti stati d'animo. IBM, col suo software Tone Analyzer che sfrutta la potenza di calcolo del supercomputer Watson, rappresenta forse l'eccellenza in fatto di analisi lessicale dei testi. Chi sta cercando di conquistare il mercato degli assistenti vocali – Amazon, Google e Apple – da tempo cerca soluzioni in grado di estrapolare informazioni utili sugli stati d'animo dall'inflessione della voce, dall'intonazione e dal volume di chi parla. E investe molto in ricerca e acquisizioni.

Riconoscimento facciale

Non sono solo quelli lessicali o vocali, però, i sintomi delle emozioni. Le espressioni del nostro viso rivelano, solitamente, molto di quel che sentiamo. E proprio sull'analisi dei volti si concentrano gli sforzi di molti protagonisti dell'affective computing. Come Microsoft, che rende disponibili le istruzioni del suo programma di intelligenza artificiale Emotion. O come Amazon che offre un servizio del tutto analogo, battezzato in questo caso Rekognition, con cui è possibile analizzare immagini statiche e video alla ricerca di indicatori di felicità o tristezza, con l'unica condizione di utilizzare il proprio cloud per l'archiviazione. Facebook, che come le altre aziende sopracitate ha messo a segno una serie di acquisizioni di start-up specializzate in AI e ha registrato un considerevole numero di brevetti in tema di riconoscimento automatico delle emozioni, ha chiesto la tutela brevettuale anche per un progetto che dovrebbe permettere alle macchine di desumere lo stato d'animo dell'interlocutore in base alla pressione e velocità con cui questo digita sullo schermo di smartphone e tablet.

Affectiva e Realeyes

Due delle realtà più interessanti in fatto di intelligenza emotiva artificiale sono quelle partorite da due prestigiose accademie: il Massachusset Institute of Technology e l'Università di Oxford. A Boston, da dieci anni, raccoglie finanziamenti e successi uno spin-off chiamato Affectiva che tramite software di analisi del parlato e delle espressioni facciali ha messo a punto un programma di deep learning che permette di comprendere gli stati emotivi degli esseri umani. Enorme la banca dati a disposizione, con più di sette milioni di volti.Un quarto delle aziende Fortune 500 (e cioè più di cento tra le cinquecento più grandi del mondo) hanno adottato Affectiva, convinte che sia questa la strada più breve per raggiungere obiettivi di marketing ancora più sofisticati.

Sull'altra sponda dell'Oceano incontra fortune simili l'affective computing elaborato da RealEyes. Anche in questo caso la soluzione proposta è basata sull'analisi dei movimenti del volto (tramite la cosiddetta computer vision) e dell'intonazione e lessico usato nel parlato. Anche in questo caso la finalità dichiarata è il ottimizzare l'attività di promozione dei grandi marchi, l'intelligenza emotiva artificiale impara a interpretare le reazioni di un essere umano alle immagini pubblicitarie.

Competenza culturale

“Dal momento che le emozioni umane non vengono espresse in modo unico, non c'è vera intelligenza emotiva senza un'adeguata competenza culturale” ammonisce, però, Antonio Sgorbissa, professore di Robotica all'Università di Genova e responsabile di CARESSES, progetto cofinanziato da Ue e Giappone per sviluppare intelligenza artificiale in grado di adattarsi al contesto culturale degli interlocutori. “Il gesto che si fa col capo per dire no in Europa, ad esempio, è simile a quello che più di un miliardo di persone in India fanno per annuire”. Insomma, anche per questo, siamo ancora lontani dall'avere AI in grado di comprendere le emozioni dell'interlocutore come lo facciamo noi umani.

Tuttavia, una volta migliorati gli strumenti di apprendimento automatico e dopo la loro contestualizzazione culturale, le cose dovrebbero migliorare. La strada che porta alla piena comprensione delle emozioni umane da parte delle macchine non è, quindi, breve ma sembra già tracciata.

)

)

)

)

)