Un anno di guerra in Ucraina, cosa abbiamo imparato sulla disinformazione

Mondo

Dodici mesi di conflitto ci hanno permesso di vedere più chiaro su come funzionano le campagne per manipolare l’opinione pubblica nell’universo digitale soprattutto quelle di matrice russa

All’inizio fu il fantasma di Kiev. Poi le attrici di Mariupol, i finti cadaveri di Bucha, le malefatte dei rifugiati, i laboratori di armi biologiche finanziati dagli Stati Uniti e centinaia di altre storie false, quasi false, fabbricate, distorte, troppo belle per essere vere e troppo brutte perché, pensa qualcuno, l’opinione pubblica le possa ricevere così come sono.

Un anno di guerra, oltre a migliaia di morti e milioni di profughi, ha portato con sé anche un’impennata di disinformazione digitale. Un diluvio che ha inquinato l’ecosistema delle notizie e ha probabilmente condizionato la percezione del conflitto di alcuni (anche se non sappiamo di quanti e quanto). Ma che, anche grazie all’attenzione maggiore che ha ricevuto, ha permesso di vedere più da vicino come funzionano i meccanismi delle fake news, soprattutto quelle di provenienza russa, e come si può provare a contrastarle.

Ecco qualche esempio.

Un fantasma dell’aria e la guerra sintetica

Se è troppo bello per essere vero allora probabilmente non è vero, recita il detto. Soprattutto in un’era in cui le capacità di creazione di immagini e video sono a portata di chiunque grazie a computer e programmi informatici specifici. Questa massima non vale sempre ma nel caso del cosiddetto “fantasma di Kiev” sì. La guerra era appena cominciata e sui social network già circolava il video di un presunto asso dell’aviazione ucraina che abbatteva aerei nemici. La clip finì per essere condivisa anche dal ministero della Difesa.

Il “fantasma”, come era stato soprannominato il presunto pilota, era in realtà un vero e proprio spettro digitale, nel senso che non esisteva se non in un mondo di pixel. Rappresentava il prodotto di quelli che tecnicamente vengono chiamati “media sintetici”. Smascherato, tra gli altri, dall’agenzia di stampa Associated Press, il video era stato infatti realizzato con un videogioco simulatore di volo (più tardi le autorità ucraine avrebbero ammesso la natura interamente "mitica" del personaggio). In guerra l’opinione pubblica ha bisogno di eroi e il pilota ne rappresentava un perfetto esempio. Perfetto ma realizzato col computer, e quindi falso.

Quel falso Zelenski

Sempre sul fronte dei “media sintetici”, la guerra in Ucraina ci ha regalato il primo impiego di un deepfake nella propaganda bellica. Vale a dire un passo avanti verso uno scenario a lungo paventato dagli studiosi di disinformazione. Quello in cui l’intelligenza artificiale diventa così abile nel riprodurre sembianze, movenze e voce di personaggi reali e influenti da poter creare delle clip realistiche che possono essere scambiate per vere, i cosiddetti “deepfake” appunto.

Fortunatamente non è stato il caso del video del presidente ucraino Volodymyr Zelensky che proclamava la resa diffuso nel primo mese di conflitto. Era sì un “deepfake”, ma era anche troppo dozzinale per poter seriamente ingannare. Il resto lo ha fatto la prontezza comunicativa del numero uno di Kiev che ha smentito rapidamente il contenuto e lo ha fatto per giunta con un altro video, in modo che il confronto fosse lampante. Scampato pericolo, ma solo per ora. L’evento ha dimostrato che la tecnologia esiste e può essere utilizzata anche in situazioni di crisi con finalità non certo benevole. Il che vuol dire che in futuro qualcuno, magari con prodotti più sofisticati, ci riproverà. Meglio prepararsi.

Fact-checking sospetto

A lungo il fact-checking è stato considerato la migliore contromisura contro la disinformazione. Tecniche e pratiche digitali di verifica delle informazioni sono sempre più popolari tra giornalisti e non solo. Ma proprio questa diffusione porta con sé dei rischi. E uno di questi, emerso con chiarezza nell’anno di guerra, è che qualcuno si appropri di questa attività e la pieghi a fini opposti a quelli per cui dovrebbe essere praticata.

Un esempio? Il video condiviso nel marzo 2022 da alcuni account di social media filorussi in cui si fanno le pulci a una presunta clip messa in circolazione dagli ucraini: un’esplosione nella città di Kharkiv che, secondo gli investigatori digitali di Mosca, risalirebbe al 2017 e non alla guerra in corso come sostenuto dai supporter di Kiev. Propaganda a tinte gialloblù, almeno in apparenza, smascherata da un lavoro di fact checking in piena regola, confezionato e portato avanti con tutti i crismi del caso.

Se non fosse per un particolare: le prove che il video originario, quello dell’esplosione, sia effettivamente stato fatto circolare non ci sono. Dunque, il fact checking c’è ma i fatti da verificare no. L'obiettivo della presunta verifica non è allora chiarire quello che chiaro non è. Semmai seminare ulteriore incertezza e confusione, i migliori terreni di coltura della disinformazione, soprattutto se fatta in nome del ripristino della verità.

Né vero né verosimile

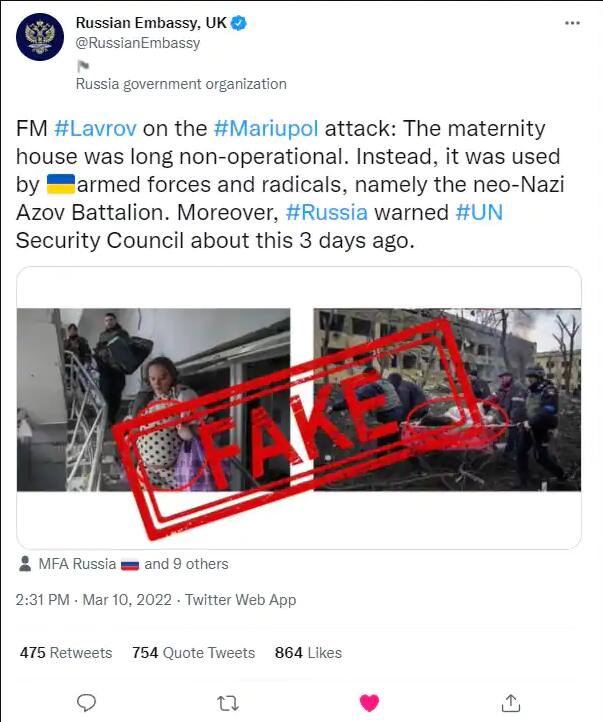

Un ospedale che non era più un ospedale. Una donna che in realtà né impersonava due. Ferite che non erano ferite e choc che non erano tali, solo abile recitazione. Salvo poi rimangiarsi tutto. Senza ammetterlo. Ma chi l’ha detto che la propaganda deve essere raffinata e sofisticata? Di sicuro non le autorità russe che - ci ha insegnato questo anno di guerra - di fronte ad accuse circostanziate e suffragate da evidenze non hanno nessuna remora ad impiegare qualunque mezzo per negarle, offuscarle e ribaltarle, anche a costo di contraddirsi.

Come nel caso del bombardamento dell’ospedale pediatrico di Mariupol nelle prime settimane di “operazione speciale”. Quando i tweet di svariate ambasciate di Mosca nel mondo hanno iniziato a seminare dubbi sull’accaduto senza troppo preoccuparsi della verisimiglianza delle affermazioni. Il nosocomio, hanno detto, non era più operativo ma occupato dal battaglione Azov (e questo nonostante lo stesso ospedale nei giorni precedenti avesse chiesto carburante per avere l’energia sufficiente a continuare le operazioni). La donna incinta ferita e fotografata dopo l’esplosione - hanno proclamato - era in realtà un’attrice pagata allo scopo che impersonava anche un’altra paziente distesa su una lettiga (anche se le fotografie mostravano due persone chiaramente distinte).

Tutte affermazioni false e facilmente dimostrate tali dalle evidenze prodotte da giornalisti e utenti della Rete. Ma, soprattutto, smentite dalle interviste alla stessa donna che alcuni media filorussi hanno effettuato nelle settimane successive. In queste conversazioni l’attrice non era più un’attrice ma, improvvisamente, di nuovo una paziente dell’ospedale. Il suo racconto diventava attendibile e serviva a smontare la “propaganda occidentale” su un attacco aereo russo al nosocomio.

Perché quel che viene detto oggi può essere sempre modificato domani. La disinformazione - ci raccontano 12 mesi di conflitto Russia Ucraina - non insegue la coerenza, che è al massimo un orpello, ma la sistematica messa in dubbio di qualunque fonte di informazione. Obiettivo finale: la sfiducia generalizzata.

La risposta “aperta”

Non ci sono bacchette magiche, dunque. E, se ce ne fosse bisogno, dodici mesi di guerra ai confini dell’Europa lo hanno dimostrato una volta di più. Ma hanno anche dimostrato che le stesse tecnologie che rendono così facile diffondere notizie false possono aiutarci ad accertare la verità dei fatti. Non è semplice, richiede tempo, pazienza e padronanza di tecniche specifiche. Ma si può fare, e il successo crescente di Bellingcat, organizzazione che utilizza fonti digitali aperte per fare attività di verifica, è sotto gli occhi di tutti. Che si tratti di geolocalizzare un’immagine per capire dove è avvenuto un determinato evento, di identificare il tipo di arma utilizzata attraverso le foto di detriti lasciati dall’esplosione, di appurare l’ora di un conflitto a fuoco dalle ombre sul terreno, la community degli appassionati di Osint (Open source intelligence) offre un contributo decisivo per chiarire che cosa è effettivamente successo, In Ucraina come altrove.

E’ un esempio contagioso. Alcuni dei migliori lavori giornalistici pubblicati durante questo anno di guerra sono stati realizzati anche grazie all’impiego di tecniche di Osint. A cominciare dalle inchieste del New York Times sui crimini commessi dall’esercito russo a Bucha. Fin da subito la propaganda di Mosca ha sostenuto che i cadaveri ritrovati nella città erano stati sistemati lì dopo che l’esercito russo aveva abbandonato la zona. Le immagini satellitari visionate dal quotidiano americano, i video raccolti sul campo, i messaggi lasciati sui social network dai soldati e ritrovati dai giornalisti hanno contribuito a smentire la ricostruzione russa, a svelare che cosa era effettivamente accaduto nella cittadina vicino a Kiev e a identificare una parte dei responsabili.

In conclusione il 24 febbraio 2023 nutriamo gli stessi timori di un anno fa sui rischi della disinformazione. Forse qualcuno di più. Ma abbiamo anche una maggiore conoscenza del fenomeno avendolo visto all'opera per così tanto tempo. E, grazie a lavori di indagine come quelli del New York Times e di Bellingcat, abbiamo la consapevolezza di avere qualche strumento in più nella cassetta degli attrezzi che ci aiuta a fare più chiarezza su ciò che accade nel mondo.

)

)

)

)

)