Intelligenza artificiale e Quantum Computing: così cambieranno le nostre vite

NOWLe due tecnologie rivoluzioneranno il nostro modo di vivere. Per scoprire cosa sono in grado di fare abbiamo visitato i laboratori IBM di Zurigo

(da Rüschlikon, Svizzera, con la collaborazione di Eric Cervi)

Come cambierà il nostro modo di vivere nei prossimi anni? Per scoprirlo abbiamo visitato il Laboratorio IBM Research di Zurigo - primo laboratorio IBM costruito all’infuori degli Stati Uniti - dove ricercatori provenienti da ogni parte del mondo lavorano su progetti di intelligenza artificiale e Quantum Computing diretti da Alessandro Curioni, responsabile tra le altre cose della ricerca aziendale di IBM in Europa, dove guida la strategia di ricerca globale del colosso dell’informatica nel campo dell’Accelerated Discovery e della Security.

GUARDA IL NOSTRO REPORTAGE INTEGRALE DAL LABORATORIO IBM RESEARCH DI ZURIGO

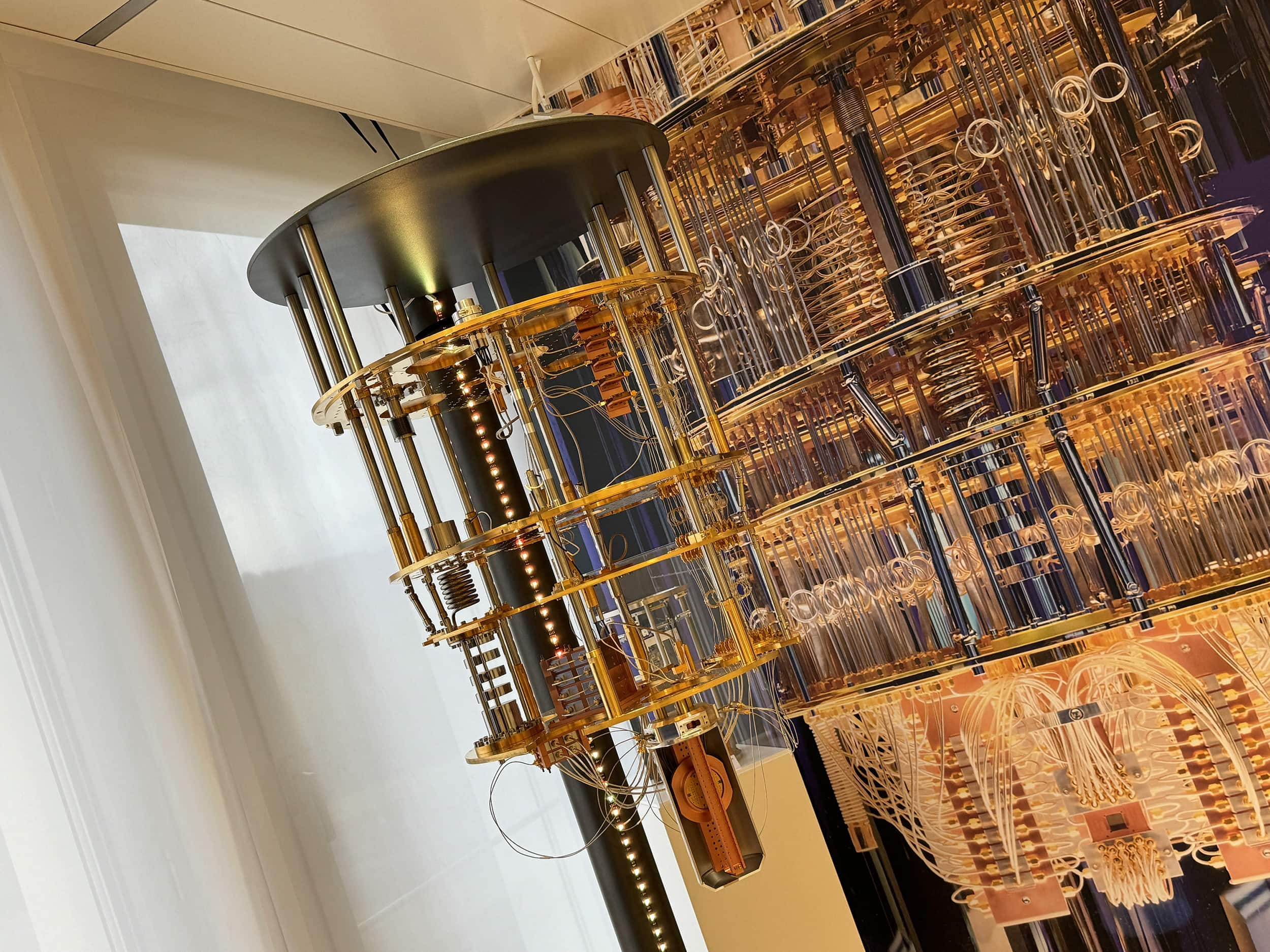

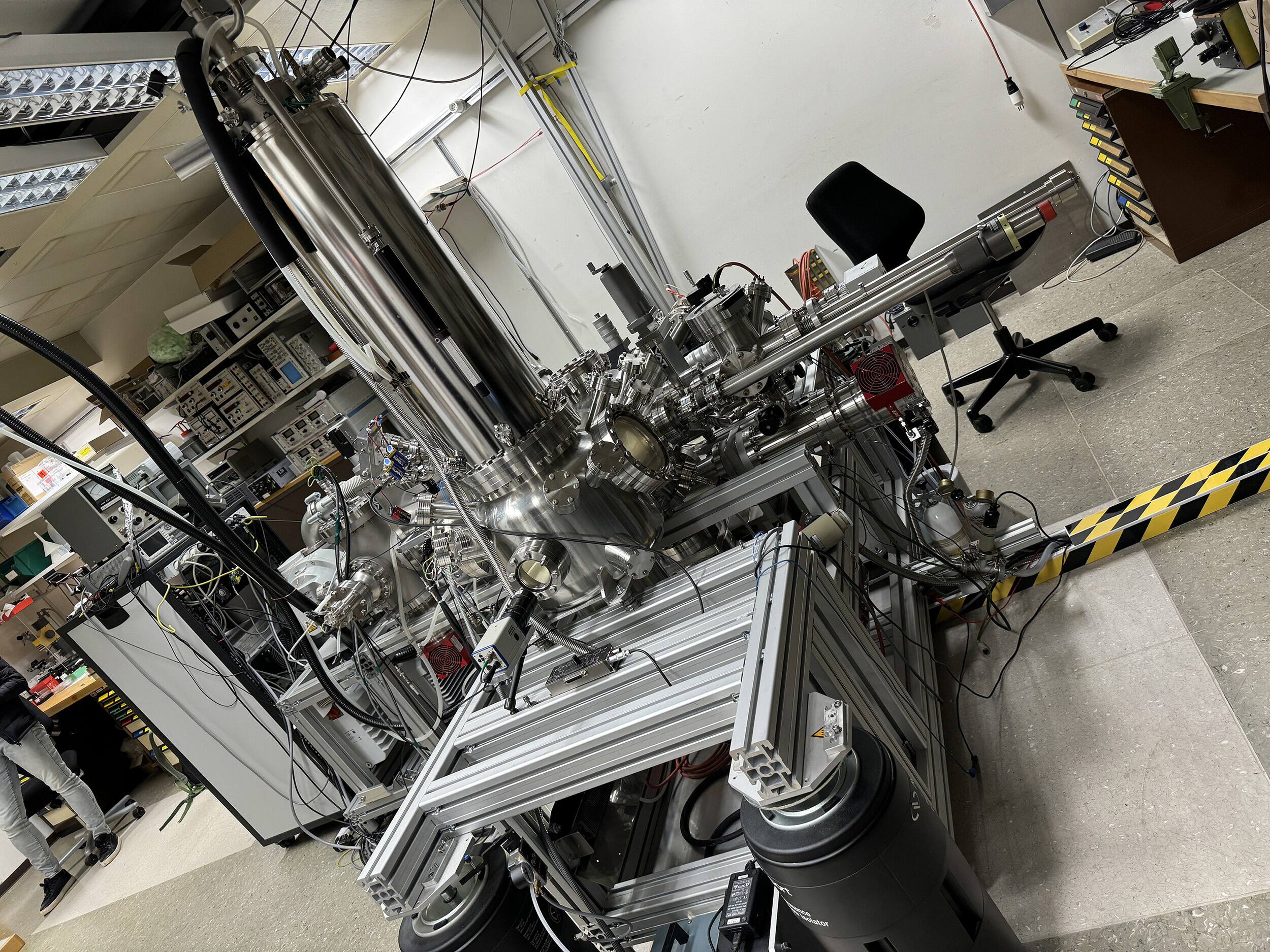

Curioni, esperto riconosciuto a livello internazionale nell’area del calcolo ad alte prestazioni e della scienza computazionale, dove il suo pensiero innovativo e i suoi progetti hanno contribuito a risolvere alcuni dei più complessi problemi scientifici e tecnologici nei settori della sanità, dell’aerospazio, dell’elettronica e dei beni di consumo, è stato membro del team vincitore del prestigioso Gordon Bell Prize nel 2013 e nel 2015. Nella lunga intervista che gli abbiamo fatto, di fronte a uno dei computer quantistici utilizzati da IBM per la ricerca, Curioni spazia dall’importanza dell’intelligenza artificiale all’etica, dalla fisica alla cybersecurity alle prospettive future della tecnologia.

Di seguito la nostra intervista integrale.

Curioni: ecco qual è oggi il ruolo dell’intelligenza artificiale

“In questo laboratorio abbiamo sviluppato delle tecnologie trasformazionali nel mondo dei computer grazie a ricercatori che hanno vinto numerosi premi, tra cui un Nobel per lo sviluppo del Microscopio a Effetto Tunnel, primo strumento che ha reso possibile la manipolazione della materia su scala nanometrica, quindi lo strumento che ha reso possibile la nanotecnologia, e un altro Nobel sulla Superconduttività ad Alte Temperature, quindi l’abilità di creare materiali che siano in grado di condurre l’elettricità a temperature più alte”. Oggi il ruolo dell’intelligenza artificiale - continua Curioni - è quello di analizzare una quantità di dati immensa ed estrarre la conoscenza. Facendolo su larga scala, questa conoscenza ci permette di prendere decisioni migliori, perché basata su una conoscenza più grande di quella presente nella nostra testa. Adesso, con i sistemi sempre più veloci e potenti, l'intelligenza artificiale è in grado di imparare direttamente dai dati, senza avere persone che annotano dati e insegnano alla macchina. Questo significa che adesso riusciamo a creare modelli che risolvono particolari problemi con minori investimenti. E questo fa sì che se l’intelligenza artificiale prima poteva venire applicata solo in pochi casi, adesso la possiamo applicare in tutti i processi decisionali".

Curioni: ecco la rivoluzione del computer quantistico

Qual è l’importanza del Quantum Computing, chiediamo a Curioni? “Il Quantum Computing è una nuova tecnologia di computer che al posto di basarsi sulle leggi della fisica classica e della teoria dell’informazione classica, dove tutto può essere codificato in 0 e 1, è in grado di decodificare le informazioni su “qubit” e non bit. Questa unità può avere tutte le combinazioni possibili tra 0 e 1, e quando dei qubit interagiscono tra loro sono in grado di accrescere il numero di stati di informazioni che è possibile maneggiare. Il computer quantistico, in altre parole, è in grado di fare un tipo di computazione che non era possibile fare su un computer classico, perché la complessità di queste operazioni era troppo grande. Quindi con il computer quantistico sono in grado di capire cose che non riuscivo a capire prima, non riuscivo a simulare, e questo ci aiuterà a risolvere i problemi che abbiamo oggi: ad esempio simulare delle proteine senza fare approssimazioni come avviene adesso, progettare farmaci in modo più oculato, disegnare materiali in modo più accurato, prendere decisioni su progetti che hanno moltissime variabili; trovare strutture all’interno di dati molto complessi, come l’ago nel pagliaio. Per questo avrà un impatto enorme”. Durante la nostra intervista ci fa compagnia un rumore continuo che proviene proprio dal computer quantistico: è il sistema di raffreddamento. “Per sostenere uno stato quantistico che può stare tra 0 e 1 - ci spiega Curioni - devo isolare questo stato dal mondo classico. Tra le diverse interazioni, quella fondamentale è l’interazione col calore: se il mio sistema quantistico interagisce con le molecole che stanno nell’aria, che hanno un’energia termica dentro, automaticamente il sistema diventa classico. Invece per farlo funzionare lo devo raffreddare il più possibile vicino allo 0 assoluto (-273,15 gradi centigradi, ndr) e il rumore è dovuto proprio al sistema di raffreddamento, che utilizza la refrigerazione per diluizione: gas con isotopi diversi vengono diluiti, e questa diluizione assorbe calore, riuscendo a togliere calore anche a qualcosa che è più freddo del gas stesso”. È di pochi giorni fa, tra l’altro, l’annuncio di IBM che ha presentato il processore quantistico “più performante al mondo” chiamato IBM Quantum Heron con un’architettura di nuova costruzione che migliora fino a cinque volte la riduzione di errori rispetto alla precedente generazione, insieme a Quantum System Two, il primo computer quantistico modulare.

Curioni: da un grande potere deriva una grande responsabilità

Prima di congedarci, chiediamo a Curioni se dobbiamo temere la diffusione sempre più marcata dell’intelligenza artificiale: “Più la tecnologia è potente, più è trasformazionale, più gli effetti positivi aumentano; ma così aumentano anche gli effetti negativi. Questo è il motivo per cui nell’intelligenza artificiale è cruciale creare delle regole, dei guardarail, per dare una direzione precisa a quello che si deve fare e a quello che non si deve fare. Stessa cosa avviene per la tecnologia quantistica, che permette di fare calcoli potentissimi. Dunque è fondamentale la responsabilità: qualsiasi tecnologia sviluppiamo, dobbiamo farlo in modo responsabile, e dobbiamo anche creare strutture che facciano sì che chiunque sviluppi una tecnologia trasformazionale, la sviluppi in modo responsabile. Moltissime persone temono che la macchina diventerà più intelligente dell’essere umano: starà a noi dimostrare che siamo più intelligenti, e riusciremo a dimostrarlo soltanto se riusciremo a massimizzare i lati positivi per il beneficio della società e dell’uomo e minimizzare quelli negativi”.

Cosa si fa nel Centro di ricerca IBM di Zurigo

Il centro di ricerca di Zurigo, nato nel 1956, è uno dei 12 laboratori di ricerca globali di IBM. Prima sede europea di IBM Research, è stato creato, oltre che per perseguire una ricerca all’avanguardia per le tecnologie informatiche di domani, anche per coltivare stretti rapporti con partner accademici e industriali, essere uno dei principali luoghi di lavoro per ricercatori di tutto il mondo, promuovere le donne nel campo dello STEM e contribuire a guidare l’innovazione europea. Attualmente vi lavorano ricercatori provenienti da più di 45 Paesi e vanta numerose collaborazioni con altri enti universitari e di ricerca come il Cern o il Politecnico Federale di Zurigo (ETH).

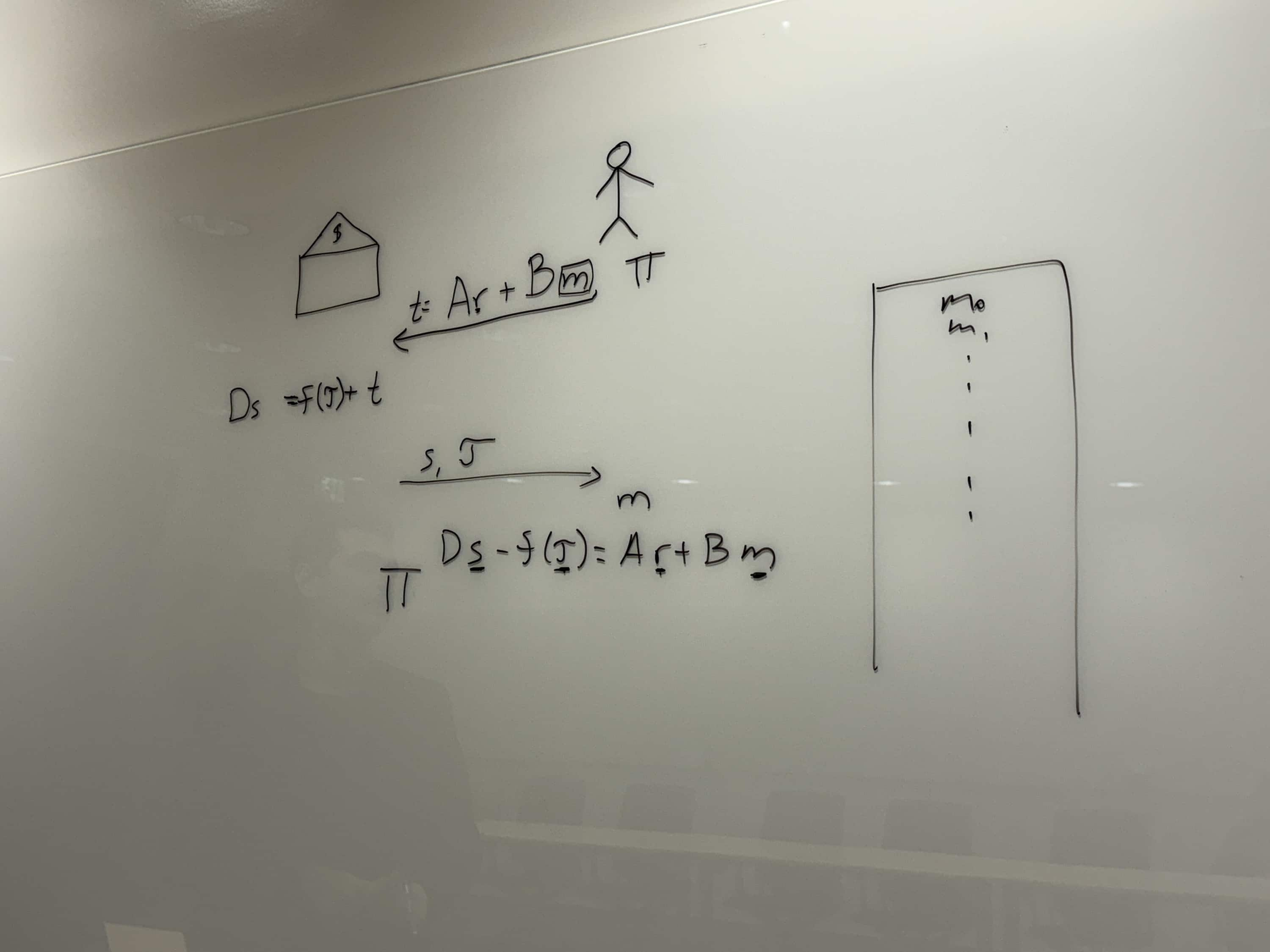

La ricerca sulla crittografia

Uno dei problemi che può creare (involontariamente) il Quantum Computing è che riesce a rompere le chiavi crittografiche che oggi utilizziamo su internet, quelle che sono alla base del funzionamento delle password. “Negli ultimi sei anni - ci spiega Vadim Lyubashevsky, ricercatore del Crypto Lab - abbiamo lavorato per standardizzare dei nuovi algoritmi che andranno a sostituire quelli attuali. Si tratta di qualcosa di estremamente importante, perché anche se non abbiamo computer quantistici in grado di bucare la crittografia di oggi, malintenzionati potrebbero salvare delle informazioni e poi decriptarle magari tra vent’anni, quando i computer quantistici saranno più semplici da reperire”. Lyubashevsky ci racconta che da parte degli enti regolatori c’è stata una grossa spinta per sostituire i metodi crittografici utilizzati oggi, e il nuovo metodo studiato a Zurigo e proposto da IBM è stato selezionato per essere standardizzato: l’uso inizierà nel 2030 dopo che una prima fase di test e di transizione partirà proprio nei prossimi mesi. “Prima di mettere in cantiere una nuova tecnologia la disegnamo, la progettiamo. E ora stiamo progettando qualcosa di molto interessante - racconta ancora Lyubashevsky - cioè come avere massima privacy e massima sicurezza nell’uso del denaro digitale. La moneta digitale in futuro sostituirà completamente le banconote, e questa tecnologia richiede una crittografia molto complicata, che deve essere sviluppata velocemente. Anche in questo caso tra circa un anno inizieremo a fare dei test affinché il denaro digitale sia resistente a eventuali attacchi da parte dei computer quantistici”.

Di seguito la nostra intervista integrale a Vadim Lyubashevsky, ricercatore del Crypto Lab.

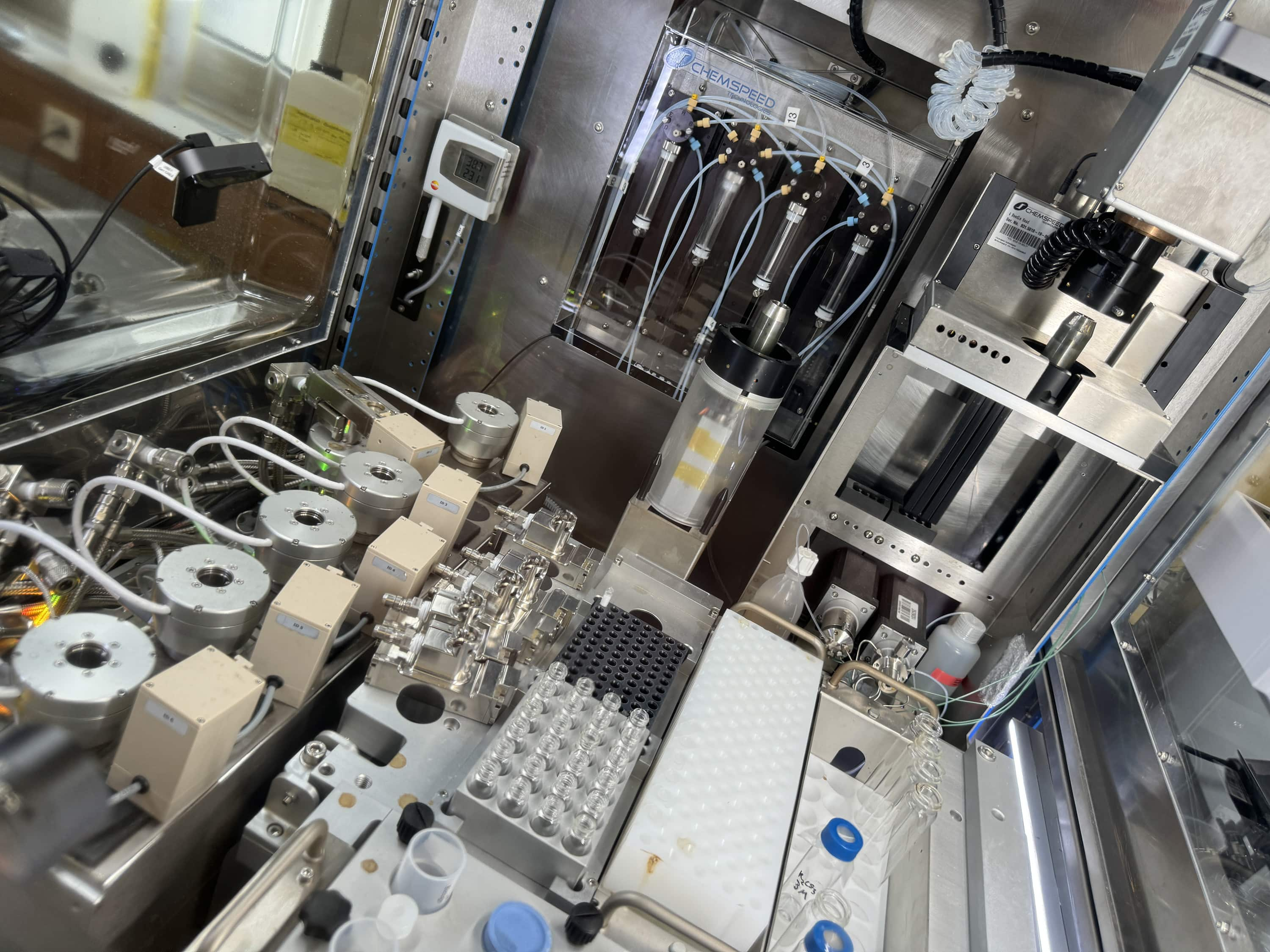

Il laboratorio di chimica

Altro esempio di come l’intelligenza artificiale possa aiutare i ricercatori di tutto il mondo lo troviamo nel Laboratorio di Chimica, gestito da ricercatori italiani. Qui è stato costruito il primo prototipo di laboratorio completamente controllato dall’intelligenza artificiale. I ricercatori, in particolare, hanno trasferito alle macchine tutta la conoscenza della chimica organica per creare un sistema in grado di eseguire ricette attraverso un robot che in automatico può sintetizzare molecole, seguendo le raccomandazioni dell’intelligenza artificiale. Sembra qualcosa di molto complicato, ma l’idea, nata nel 2019, è geniale: permette ai chimici di evitare la ripetizione delle stesse operazioni e dei compiti non stimolanti e allo stesso tempo evita che maneggino composti pericolosi. La piattaforma, così come una sorta di “ChatGPT della chimica”, è utilizzata da oltre 30mila ricercatori in tutto il mondo, e esegue e traduce dei prompt facendo lavorare il robot al posto dell’uomo, come ci spiega il Senior Research Scientist Matteo Manica: “Questo tipo di tecnologia può essere molto efficace nell’esplorare la sintesi di nuovi composti, dove non è nota a priori la sintesi, e in condizioni in cui non si conoscano quali sono le condizioni sperimentali per sintetizzare una molecola. Il grande vantaggio è che usando l’intelligenza artificiale siamo in grado di creare piani di sintesi ed eseguirli automaticamente 24 ore su 24, 7 giorni su 7 sulla piattaforma robotica, con un minimo intervento umano”.

Un elemento interessante che nasce dalla nostra chiacchierata è quello della competitività: negli ultimi tempi è diventato sempre più difficile, per via del costo del lavoro, competere con l’Asia nel campo della chimica: con questo tipo di robot è possibile invece tornare ad essere competitivi: “Questo è un perfetto esempio - spiega ancora Manica - di come grazie all’intelligenza artificiale i robot possano lavorare senza sosta, agendo in sinergia con un chimico, che può fare lo stesso lavoro in maniera molto più fluida e senza le operazioni tediose, in modo che si possa concentrare su quelle che richiedono di più l’impegno intellettuale”.

La nostra intervista all’italiano Matteo Manica, Senior research scientist IBM Research.

Il Microscopio a Effetto Tunnel

Avevamo scritto del Microscopio a Effetto Tunnel, per cui il Centro di Ricerca ha vinto un premio Nobel per la Fisica nel 1986. Per scoprire come funziona e quali sono gli studi che vengono compiuti attualmente ci spostiamo sotto terra, in un’area soggetta a meno vibrazioni. Qui è installato un grande Microscopio a Effetto Tunnel che insieme a un Microscopio a Forza Atomica (AFM) viene utilizzato, ci spiega il ricercatore Leo Gross, per osservare da vicino le singole molecole.

Attraverso questi macchinari e le tecnologie del computer quantistico, in particolare, è anche possibile creare nuove molecole e, sempre con il microscopio, studiarne le reazioni. Al momento della nostra visita era in corso uno studio sulla fuliggine: “Quello che facciamo qui - racconta Gross - è studiare miscele molecolari complesse: spesso ci sono dei materiali che comprendono moltissime molecole che si riescono a studiare solo in maniera approssimativa. Noi invece stiamo studiando la formazione della fuliggine, e in particolare come particelle di fuliggine si creino in un motore a combustione: questo può aiutarci a progettare una combustione più pulita”.

Ecco la nostra intervista al ricercatore Leo Gross.

Ai computer i sensi dell’olfatto e del gusto: il progetto Hypertaste

Sono tanti i progetti sviluppati all’interno del Laboratorio IBM Research di Zurigo. Hypertaste studia come digitalizzare i sensi dell’olfatto e del gusto. Per la serie: come insegnare a una macchina a odorare o a gustare un cibo o un liquido? Attraverso il machine learning è stato costruito un kit per sviluppatori per creare una sorta di impronta digitale dei liquidi complessi. Questo sistema è in grado di testare vini garantendone la provenienza e la qualità, oppure stimare le proprietà sensoriali di prodotti commerciali come il caffè.

Ma il sistema potrebbe anche essere applicato alle analisi cliniche. “Quello che facciamo - ci spiega il ricercatore Gianmarco Gabrieli - è registrare l’impronta digitale di liquidi e scoprirne dei modelli che sono nascosti all’interno dell’intercorrelazione tra i diversi composti chimici. Quello che prevediamo - continua - è che il sensore possa essere utilizzato dalle industrie per cercare di scoprire nuove ricette di prodotti oppure da ricercatori per effettuare analisi ed accertare provenienza e qualità”.

Di seguito l’intervista al ricercatore italiano dell’IBM Gianmarco Gabrieli.

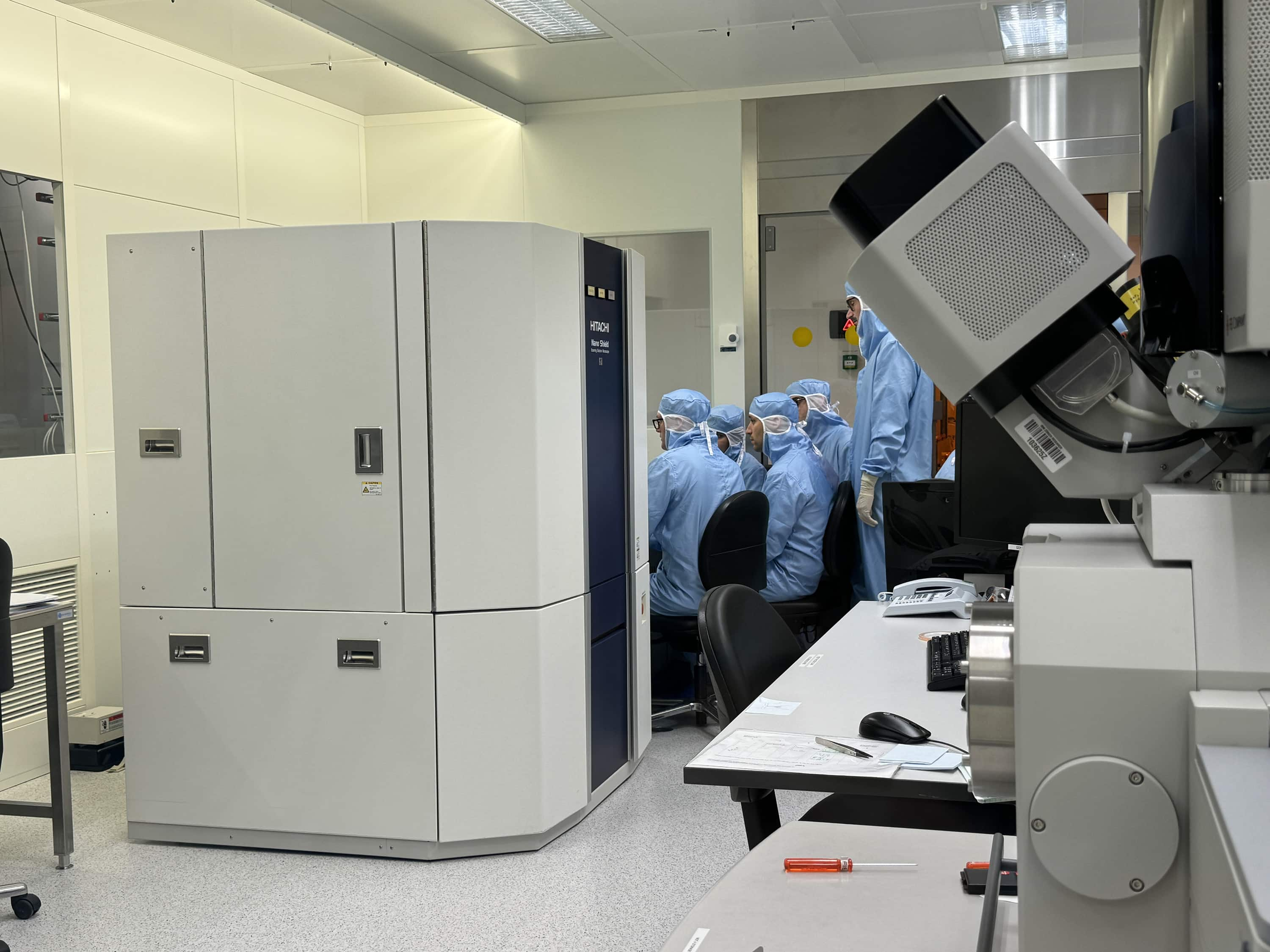

Il laboratorio di nanotecnologie

All’interno dei laboratori IBM Research di Zurigo un ampio spazio è dedicato al laboratorio di nanotecnologie. Si tratta di uno spazio creato in collaborazione con il Politecnico Federale di Zurigo a cui è possibile accedere solamente indossando tute speciali che impediscono a particelle che provengono dal nostro corpo o dai nostri vestiti di contaminare l’ambiente. Questo perché gli scienziati devono lavorare con dispositivi nanoscopici centomila volte più piccoli di un capello: basterebbe che qualsiasi elemento esterno cadesse sul piano di lavoro per distruggere migliaia di dispositivi in un batter d’occhio.

“Alcuni dei dispositivi nanoscopici che studiamo in questi laboratori - ci spiega Eva De Leo, manager italiana del Nanotechnology Center - finiranno nei computer o nei cellulari del futuro. Qui, ad esempio, studiamo la miniaturizzazione dei transistor: vogliamo renderli sempre più piccoli ed efficienti, facendo sì che consumino meno energia aumentando, allo stesso tempo, le potenze di calcolo”. Piccola curiosità: all’interno del laboratorio è presente un’area studiata per essere totalmente priva di rumori acustici, campi elettromagnetici, fluttuazione di temperatura e qualsiasi tipo di vibrazione: questo consente ai ricercatori di lavorare su dispositivi molto piccoli e manipolare singolarmente molecole o strutture con pochi atomi. All’interno dei laboratori “a rumore zero”, effettivamente, si “ascolta” un silenzio assoluto, mai provato prima.

Di seguito la nostra intervista integrale alla ricercatrice italiana Eva De Leo, manager del Nanotechnology Center.

L’importanza dei nastri

Non tutti sanno che la maggior parte dei nostri dati è archiviata su nastri, e non su chissà quali server dotati di hard-disk allo stato solido super veloci. A svelarcelo il ricercatore Mark Lantz, che dirige il Laboratorio dei Nastri. IBM, in particolare, è impegnata nello studio - e nella commercializzazione - di nastri magnetici per l’archiviazione. Basti pensare che il business dei nastri è molto conveniente per le grandi aziende che lavorano con data center perché costa 4 volte meno degli hard-disk e la loro creazione, così come il loro funzionamento, produce molte meno emissioni (fino al 96 per cento in meno). Inoltre, mentre per molte tecnologie di archiviazione la crescita della capacità nel tempo è rallentata, il nastro ha un forte potenziale di migliorare la propria capacità in futuro. E il team è impegnato proprio nell’esplorazione di limiti dei nastri e al suo superamento.

I nastri, lunghi anche 200 metri, sono letti con una velocità di 12 metri al secondo, e la velocità di trasferimento dati è più lenta degli hard-disk tradizionali (circa 400 MB al secondo): i nastri sono però più sicuri perché se archiviati bene possono resistere almeno per trent’anni; inoltre quando il dato è archiviato non è possibile manometterlo se non prendendo fisicamente il nastro e inserendolo in un lettore. “Si tratta di una tecnologia davvero fondamentale per i grandi data center di oggi - racconta Lantz - e la nostra ricerca punta proprio a migliorare la capacità dei nastri e la velocità di trasferimento. Questa tecnologia è usata dalle più grandi aziende che lavorano con il cloud. Qualche anno fa, ad esempio, c’è stato un grosso incidente in un data center di Google, che ha causato la cancellazione di numerosissimi account Gmail. Ma Google è stata in grado di recuperare tutti i dati grazie proprio a un backup effettuato su nastro. Sono molte le istituzioni che usano questa tecnologia, ad esempio quelle bancarie per salvare i backup delle transazioni. Se usi una carta di credito usi automaticamente il nastro, anche se non lo sai”.

La nostra intervista a Mark Lantz, Research scientist.

)

)

)

)

)