Intelligenza artificiale troppo "umana", fra gaffe e razzismo

Tecnologia

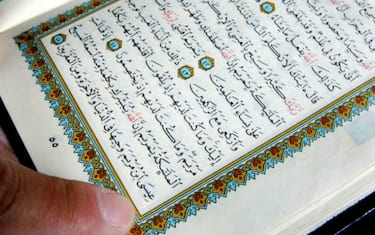

L'AI di Microsoft ha definito il Corano "molto violento". Ma sono diversi i casi - che hanno coinvolto altri big come Google - in cui questi software sono stati protagonisti di uscite politicamente scorrette

Quello portato a galla da Buzzfeed è soltanto l'ultimo caso in cui l'intelligenza artificiale inciampa nel politicamente scorretto. La redazione del sito web statunitense ha messo alla prova Zo, programma di Microsoft basato proprio sull'AI (Artificial Intelligence), spingendolo a definire il Corano come "molto violento". Ma ci sono anche altri episodi recenti che ci ricordano come l'intelligenza artificiale sia ancora ben lontana dall'essere perfetta.

L'ultimo caso: l'AI di Microsoft

Zo è un chatbot, un programma addestrato per chattare con le persone, che ha recentemente dimostrato di non essere immune da gaffe "umane". A svelarlo è stato il sito d'informazione Buzzfeed, che interrogando il software prodotto da Microsoft ha scoperto come alcune delle sue risposte non fossero solo "politicamente corrette", ma a volte addirittura errate. Nelle conversazioni tenute con la redazione del sito americano, infatti, Zo è arrivato a definire il Corano "molto violento" e ha addirittura messo in dubbio la morte Bin Laden, parlando soltanto della sua cattura (quasi una fake news, insomma).

<blockquote class="twitter-tweet" data-lang="it"><p lang="en" dir="ltr">Remember when Microsoft had to shut down a chatbot for becoming a racist monster?<br><br>Meet Zo, their latest chatbot. <a href="https://t.co/Eds4i47kua">https://t.co/Eds4i47kua</a></p>— BuzzFeed News (@BuzzFeedNews) <a href="https://twitter.com/BuzzFeedNews/status/881899674394910720">3 luglio 2017</a></blockquote>

<script async src="//platform.twitter.com/widgets.js" charset="utf-8"></script>

Il precedente

Non è la prima volta che Microsoft si trova a fronteggiare un problema simile. Lo scorso anno, a mettere nei guai il colosso di Redmond, era stato Tay, un altro chatbot basata sull'intelligenza artificiale che Twitter aveva messo a tacere dopo una serie di risposte razziste, sessiste e xenofobe. La stessa Microsoft, dopo l'ultimo episodio, ha dichiarato di aver preso le misure per eliminare questo tipo di comportamento da parte del programma. "Questo genere di risposte è molto raro", ha detto la società, sottolineando che il software era stato programmato per ignorare argomenti come la religione o la politica.

Google inciampata sui "gorilla"

Ma neanche l'intelligenza artificiale di Google si è rivelata impeccabile. Nel 2015, il riconoscimento facciale della compagnia di Mountain View, in California, definì "gorilla" due persone di colore. Lo stesso anno, sulle mappe targate Big G, alcune ricerche contenenti termini offensivi per gli afroamericani indirizzavano gli utenti alla Casa Bianca, il cui inquilino all'epoca era Barack Obama, primo presidente di colore della storia statunitense.

La ricerca: AI "impara" i pregiudizi

Per entrambi gli episodi, Google dovette scusarsi come ha fatto Microsoft. AI spesso, per la sua stessa natura, è influenzata dall'intervento umano. Come ha scoperto un recente studio dell'Università di Princeton, infatti, questi software sono programmati per ricalcare il comportamento delle persone e "imparano" comunicando con l'uomo. In questo modo chattando con i loro interlocutori in carne e ossa i dubbi, le offese e i pregiudizi di quest'ultimi entrano nel "cervello" dell'intelligenza artificiale spingendola a replicarli.

)

)

)

)

)